五一假期转眼即逝,花了半天的时间收心准备明天的工作。今天给大家分享的这篇文章主要背景是:目前的大模型参数量比较大,为了方便大模型在有限资源上部署,以此作者使用序列蒸馏对模型进行瘦身,提出了LaMini-LM,模型参数量可降低10倍,但「本文重点是其精心制作的指令调优数据集,共计258万且开源」!

背景介绍

「指令调优」是NLP中一个新兴的范式。这种方法利用自然语言指令来引导语言模型来实现以前从未见过的任务。一系列研究表明,当使用人类编写的指令进行微调时,普通语言模型可以有效地遵循一般语言指令。最近,Wang等人的研究表明,模型生成的指令可以用于指令调优,能够有效地提高了普通语言模型响应指令的能力。

「知识蒸馏」是一个过程,用于通过从称为教师的较大模型中学习来训练称为学生的较小模型。最常用的知识蒸馏方法之一是用一个额外的目标来训练学生模型,以匹配教师模型的表示,例如逻辑、输出概率或中间激活。

目前,具有指令调优的大型语言模型(LLMs)在各种应用场景中都表现出了很强的生成能力。然而,目前开放的语言模型动不动都要数十亿的权重参数,需要大量的计算资源来进行训练和推理。「Kaplan等人认为LLM模型和数据集大小成比例」。因此,模型缩放会引发许多问题,例如对能源的消耗。此外,对于许多NLP从业者来说真正关心的问题是:如何在计算资源相对有限的情况下,实现对大型语言模型的研究。

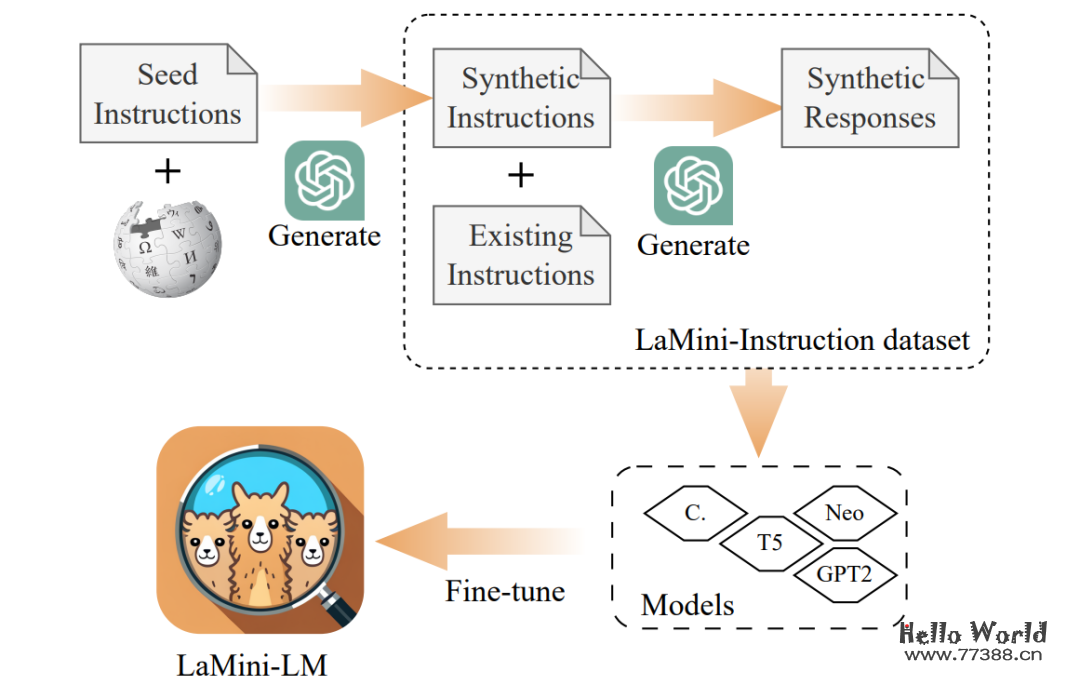

针对以上背景,「作者提出了LaMini-LM,其模型大小明显小于大多数现有的指令调优模型」。具体是通过使用LLM的序列蒸馏(也称为离线蒸馏)开发了LaMini-LM模型。虽然在最近的工作中也进行了类似的尝试,但本文针对前人工作的存在不足:(i)小规模的蒸馏数据集;(ii)多样化受限;(iii)模型数量有限;(iv)没有对模型的性能进行全面评估和分析。此外,以前的工作中提出的模型仍然是相对计算密集型的,模型的参数通常在7B到13B之间,这使得它们难以在资源受限的环境中部署,特别是对于资源不足的机构。

LaMini-LM

作者方法思想主要包括两个部分,第一进行数据生成,第二就是利用数据集对模型进行微调。整体方法如下所示:

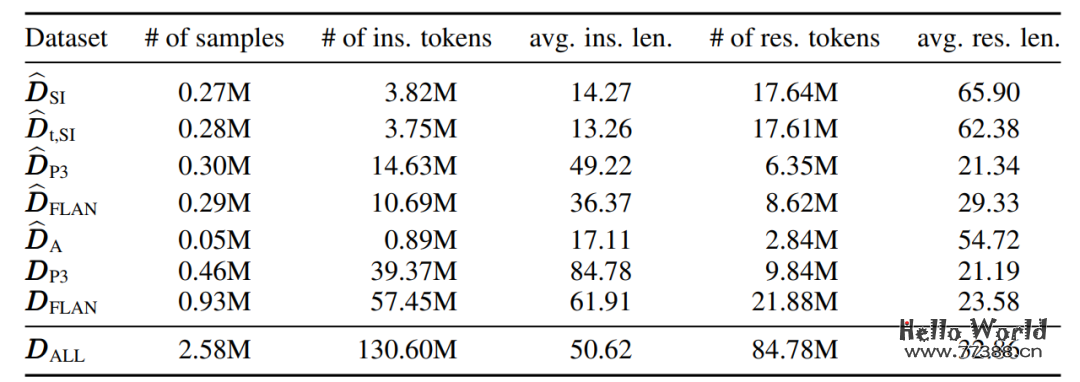

数据生成

在数据生成方面,作者整理了来自各种先前数据集的指令,例如:self-instruct、P3、FLAN和Alpaca。此外,使用 ChatGPT (gpt-3.5-turbo) 来生成补充说明,强调在提示中遵守现有的人工编写说明的多样性。这种方法被称为示例引导指令生成。为了进一步增加生成文本的多样性,我们还引入了主题引导指令生成方法。随后,使用 gpt-3.5-turbo 为每条指令生成响应。具体的:

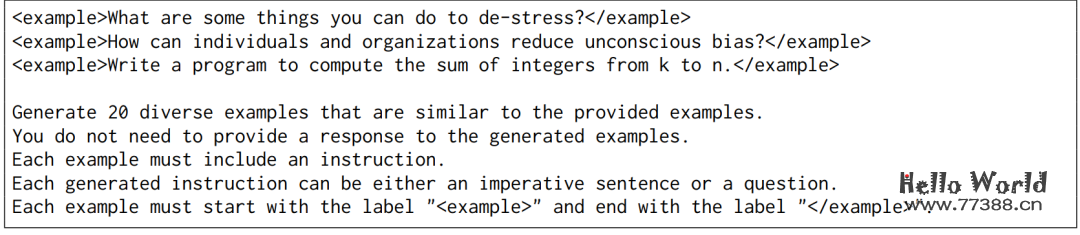

「在指令生成阶段」,「作者介绍了两种生成指令的策略,分别为示例引导和主题引导」。「示例引导」:作者针对每个提示给出三个随机示例并对生成数量进行限制,没有对语言、输出长度和指令类型提供明确的限制,而是只指示gpt-3.5-turbo生成一系列符合给定示例并坚持所需输出格式的示例。如下图所示:

「主题引导」:作者从维基百科中收集了几个常见的主题来指导生成过程,首先从维基百科收集了总共220万个分类。这些类别是根据以下两个需求进行筛选的。首先,类别必须少于三个词。其次,类别必须包含10个子类别和50页以上。通过手工检查,得到了3.5K 个作为共同主题的类别的列表。如下图所示:

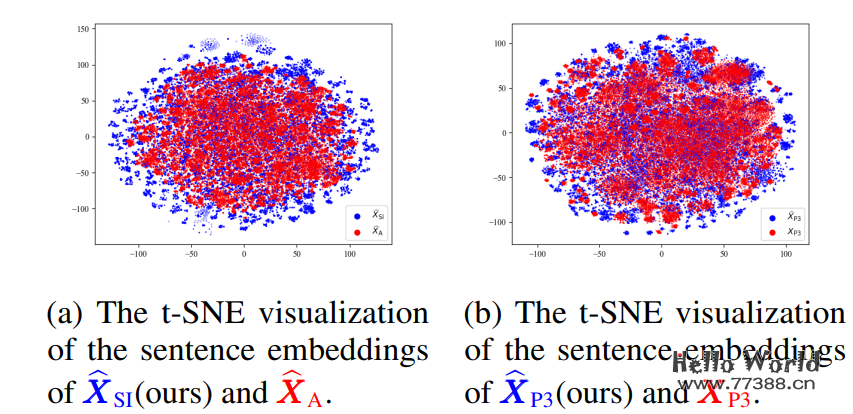

「在数据探索分析阶段」:作者的分析侧重于数据集的几个方面,包括基本统计数据、多样性和人类评估。语义多样性如下图所示:

词汇多样性如下图所示:

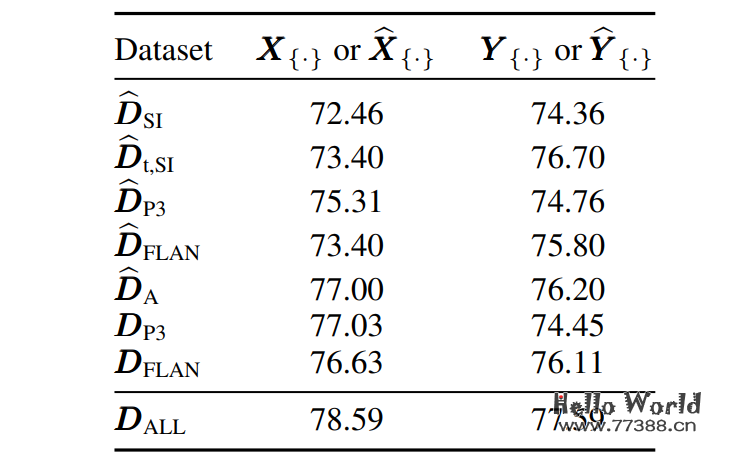

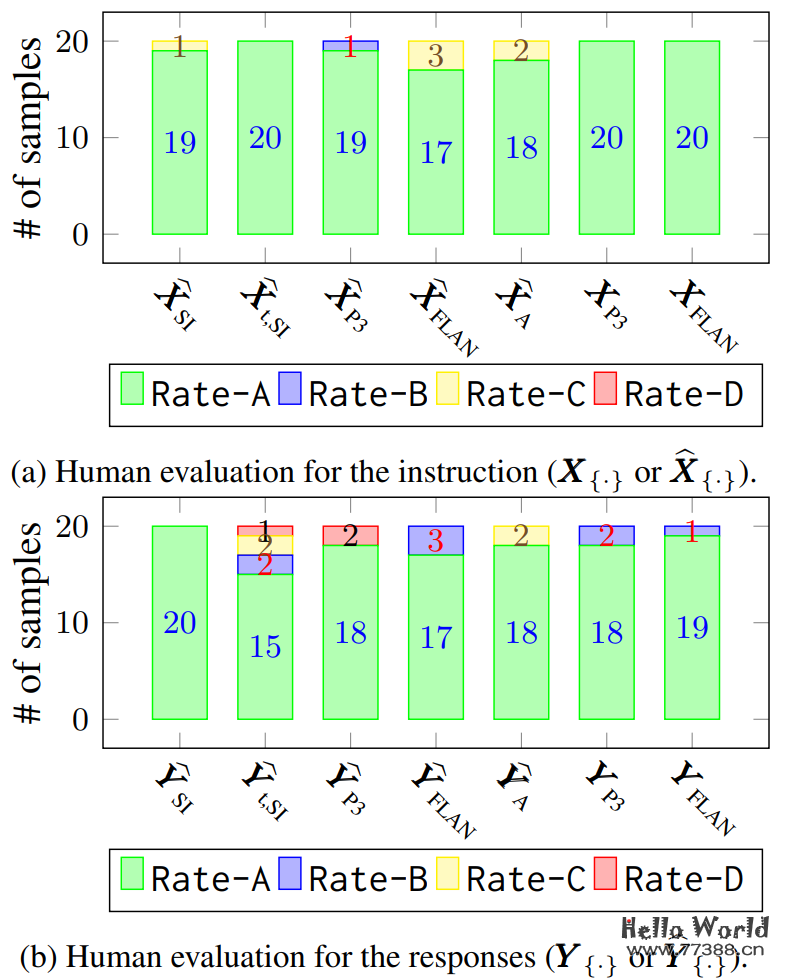

人工评估如下图所示:

模型训练及结果

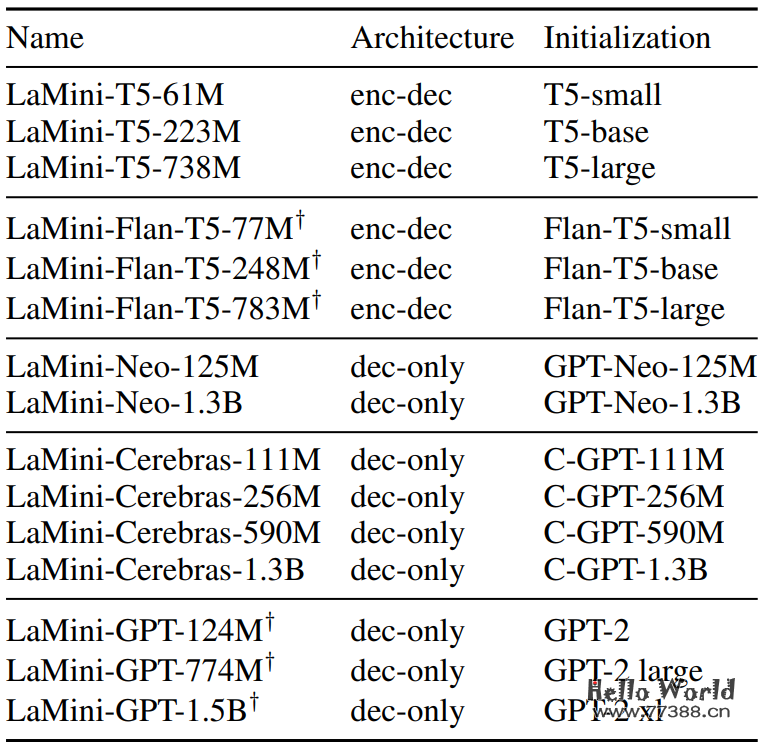

生成数据集后,作者微调了几个具有不同大小(从 61M 到 1.5B)和架构(encoder-decoder 和 decoder-only)的较小语言模型。此外,还比较了具有相同架构的模型的不同变体。具体的基准模型,包括 T5、Flan-T5、Cereberas-GPT、GPT-2 和 GPT-Neo。如下表3所示:

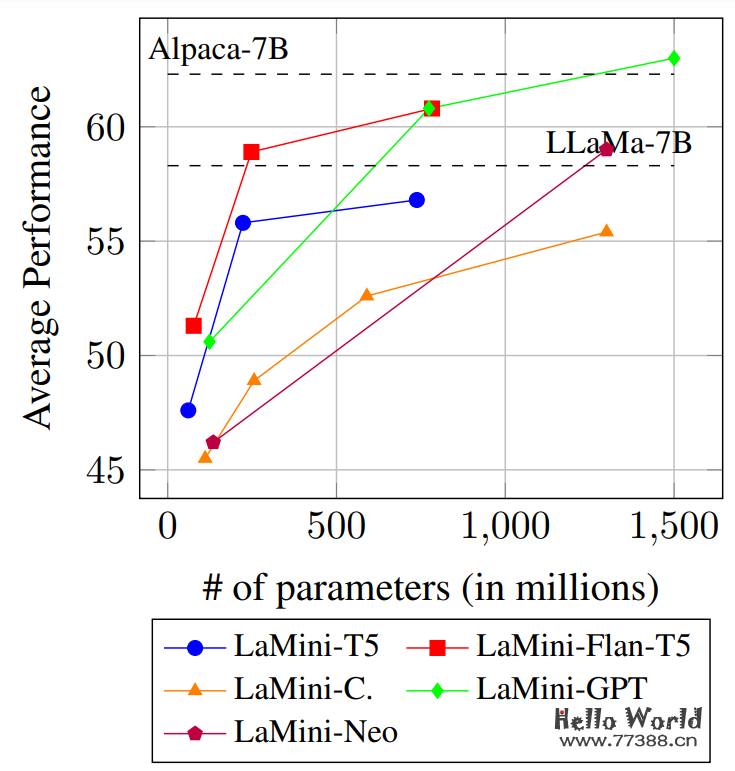

LaMini-LM的编码器-解码器模型和仅解码器模型在下游NLP任务上的性能比较。水平虚线表示Alpaca-7B和LLaMa-7B 给出的平均性能。

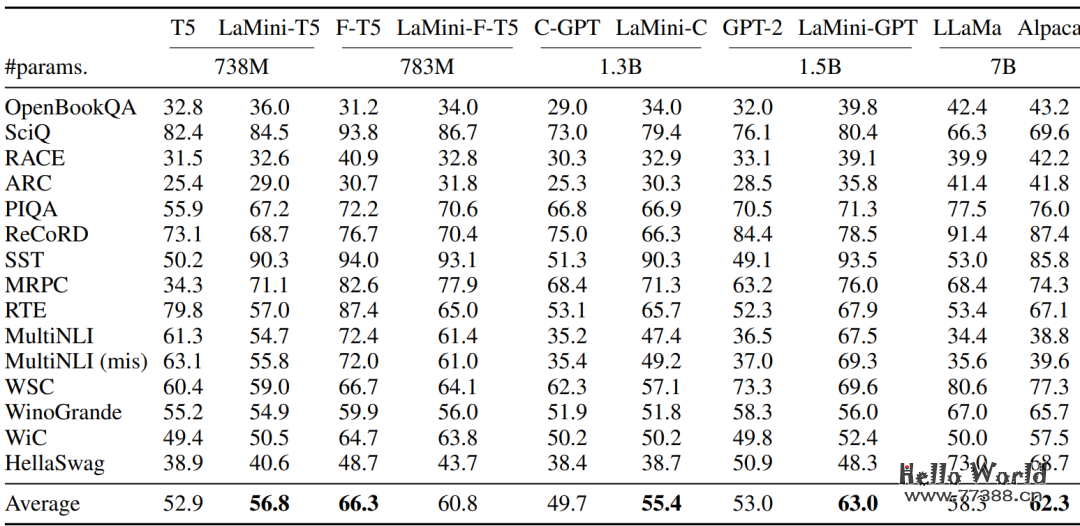

在15个NLP任务上的自动评估结果。最佳平均结果以粗体突出显示。F-T5和LaMini-F-T5分别表示Flan-T5和LaMini-Flan-T5。C-GPT和LaMini-C分别表示Cerebras-GPT 和LaMiniCerebras。

本文来源:微信公众号:AINLPer,作者:ShuYini

原文链接:https://mp.weixin.qq.com/s/PEjx-Uy7oV0mU6OEAH6NGA

本站资源部分来自网友投稿,如有侵犯你的权益请联系管理员或给邮箱发送邮件PubwinSoft@foxmail.com 我们会第一时间进行审核删除。

站内资源为网友个人学习或测试研究使用,未经原版权作者许可,禁止用于任何商业途径!请在下载24小时内删除!

如果遇到评论可下载的文章,评论后刷新页面点击“对应的蓝字按钮”即可跳转到下载页面!

本站资源少部分采用7z压缩,为防止有人压缩软件不支持7z格式,7z解压,建议下载7-zip,zip、rar解压,建议下载WinRAR。

温馨提示:本站部分付费下载资源收取的费用为资源收集整理费用,并非资源费用,不对下载的资源提供任何技术支持及售后服务。