-

卡内基梅隆 && 清华 | Prompt2Model:利用大模型Prompt,实现专有NLP模型生成!

引言 随着大型语言模型 (LLM) 的应用,只需使用自然语言描述任务并提供一些示例,人们就能够方便的通过Prompt创建NLP系统。 然而,相比传统的专用NLP模型,大型语言模型仍然存在计算资源紧张等问题。 为此,本文提出了Prompt2Model平台架构,采用自然语言描述任务,并用它来「训练有利于部署的专用模型」。 实验结果显示:Prompt2Model训练的模型的「性能比ChatGPT的结果…- 666

- 0

-

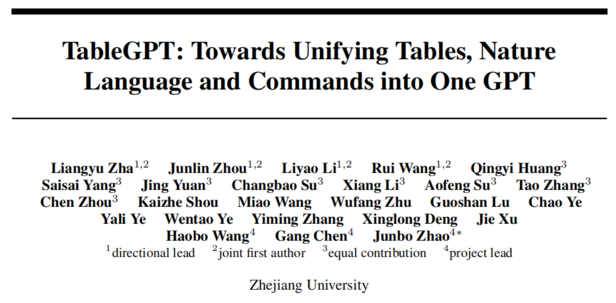

浙大发布TableGPT,AI自动增删改查表格,实现自动分析数据、作图和建模

TableGPT: Towards Unifying Tables, Nature Language and Commands into One GPT 3 个月前,北大团队推出了 ChatExcel,让用户可以通过自然语言对话来操作 Excel 的各种功能,让人眼前一亮。但 ChatExcel 作为为了解决特定的问题而生的工具,其能力有限。 浙大团队近日推出的 TableGPT,是…- 5.5k

- 0

-

质量>数量!数据对大型语言模型(LLM)整个生命周期的影响!

引言 自去年底ChatGPT发布以来,大型语言模型(LLM)的性能极大的吸引了人们的注意力。在此过程中,我们逐渐的开始思考当前LLM发展过程。相比传统的自然语言模型,LLMs为什么能做到如此令人印象深刻的效果?针对该问题,尽管人们争论不断,但一项特别有影响力的进步是执行对齐的能力,这是毋庸置疑的。通俗来说,不管是通过指令信息还是检索信息,「人类已经明白如何训练LLM,使其不仅能够准确预测出下一个…- 859

- 0

-

大型自然语言模型(LLM)最新学术进展!2023年7月份,爆款论文总结!

引言 时间转瞬即逝,一个月又过去了。今天是7月的最后一天,让我们来盘一盘大型自然语言模型的发展状况。「目前总体情况看下来,其中主要涉及新的模型(LLaMA2、百聆)、Transformer研究(RetNet、LongNET、Transformer参数分析)、大模型安全推理(PUMA)、知识图谱(DiFaR)等」。所有论文下载可回复:2307论文总结 Google揭秘上下文学习 加州伯克利&am…- 1.5k

- 0

-

中科院计算所 | 推出多语言大模型:BayLing(百聆),性能媲美GPT-3.5,可在线体验!

如何用经济友好、内存节约的方式,来实现 LLM 生成能力和指令遵循能力的跨语言迁移? 2023 年过半,ChatGPT、GPT-4、LLaMA 等大型语言模型(LLM)一次次引起人们高度关注,它们具备令人惊艳的涌现能力,包括语言理解能力、生成能力、知识推理能力等等。 LLM 通常基于大规模语料训练知识表示与语言生成能力,随后在人工编写的指令数据上进行微调以实现与人类的意图对齐。因此,如何有效地进行…- 1k

- 0

-

开源大模型突破8K上下文,可商用:XGen-7b

大语言模型中,向来都只有ChatGPT以及其他。而由前 OpenAI副总裁离职创建的Claude,借着100k上下文成功出圈了,在无需微调的情况下,可以喂进整本书直接进行提问。这说明了长上下文,是大模型一个有效的突破点。 Salesforce就在昨天,一口气开源了三个模型,分别是:XGen-7b 8k base, XGen-7b 7k inst, XGen-7b 4k base。 这三个模型采用了…- 1.7k

- 0

-

提升大型语言模型(LLMs)的训练速度:推理提升30%,内存降低一倍,仅需一行代码!

引言 大型语言模型资源消耗惊人,10B以内的参数还能够一够,再大就超出范围了(个人想法)。今天给大家分享这篇文章与模型训练相关,基于pytorch,「应用混合精度降低模型训练成本,提高模型训练速度,并且只需一行代码即可实现精度切换」。研究了生成式AI模型Lit-LLaMA的推理速度,该方法可提高30%的性能,降低1倍内存。 32位Float介绍 在GPU上训练深度神经网络时,我们通常使用低于最…- 1.3k

- 0

-

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!